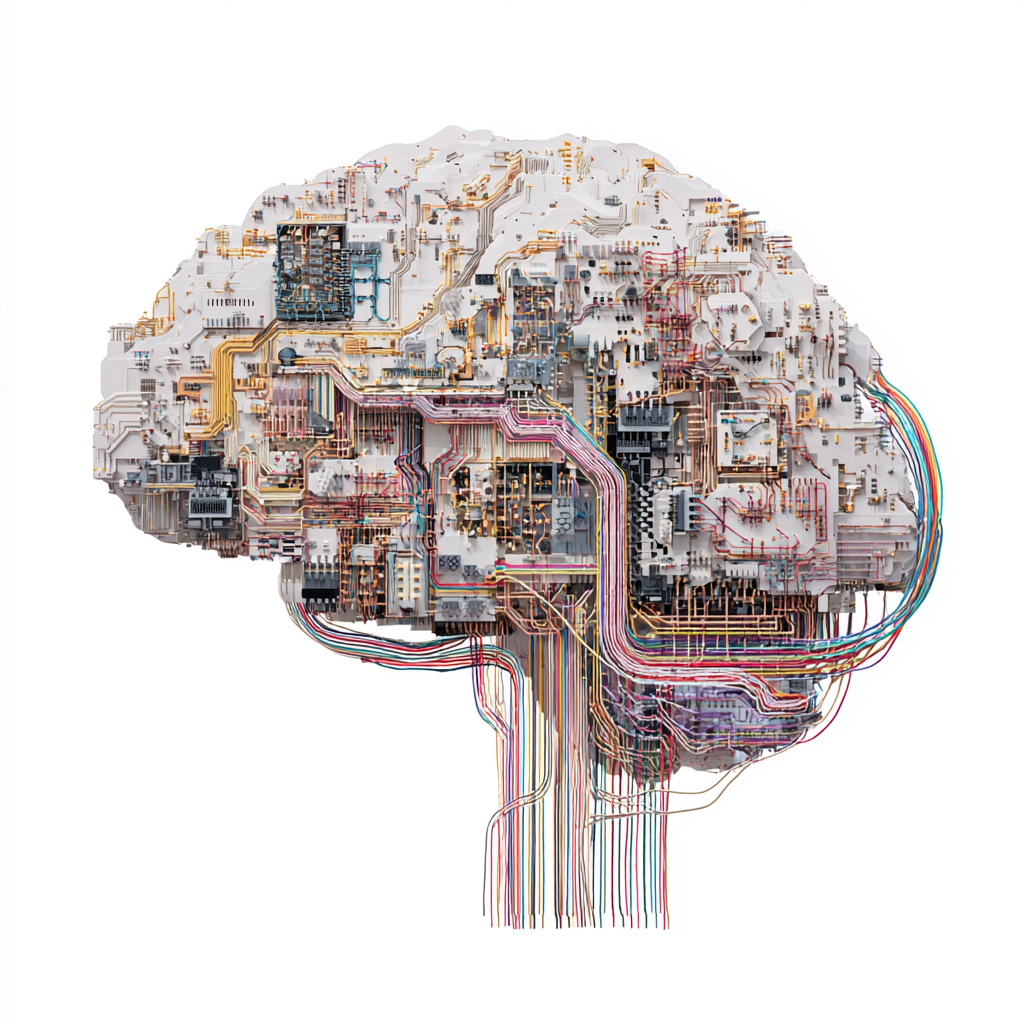

Stell dir vor, du hättest einen Computer, der nicht nur Daten verarbeitet, sondern denkt wie ein Gehirn: Er spart Energie, reagiert blitzschnell, lernt kontinuierlich und speichert Wissen lokal. Klingt nach Science-Fiction? Willkommen bei Neuromorphic Computing – dem Versuch, Silizium zum Gehirn zu machen.

Was ist Neuromorphic Computing?

Herkömmliche Computer arbeiten sequentiell: Ein Prozessor, eine Aufgabe nach der anderen, alles in Bits und Bytes. Das menschliche Gehirn dagegen: Parallel, verteilt, extrem energieeffizient.

Neuromorphe Chips kopieren:

- Neuronen → Rechenknoten

- Synapsen → Verbindungsgewichte

- Spike-basiertes Signal → Stromspitzen statt kontinuierlicher Berechnungen

Ergebnis: Ein Chip, der wie ein neuronales Netz hardwaremäßig denkt – nicht nur softwarebasiert.

Micro-LLMs: Künstliche Intelligenz auf Sparflamme

Parallel zum Neuromorphic Computing entstehen Miniatur-LLMs (Micro-LLMs): KI-Modelle, die nicht die Rechenpower eines Rechenzentrums brauchen, sondern lokal auf Geräten laufen:

- Smartphones

- Drohnen

- Edge-Geräte

Vorteile:

- Echtzeit-KI ohne Internet

- Energieverbrauch drastisch reduziert

- Datenschutz: Alles bleibt lokal

Anwendungen 2025

- Wearables & AR: Smartwatches analysieren Vitaldaten sofort und geben Empfehlungen.

- Autonome Systeme: Drohnen und Roboter treffen blitzschnelle Entscheidungen.

- IoT-Geräte: Kühlschränke, Lampen und Roboter lernen, reagieren autonom.

- Medizinische Analyse: Bildgebung und Diagnostik direkt auf dem Gerät.

Technik dahinter

Neuromorphe Chips arbeiten spike-basiert: Anstelle von 0 und 1 senden sie kurze Energieimpulse (Spikes), ähnlich wie Synapsen.

- Chips wie Intel Loihi oder IBM TrueNorth verfügen über Millionen Neuronen und Milliarden Synapsen.

- Energieverbrauch ist minimal – ein Loihi-Chip verbraucht ca. 1 Watt, während ein klassischer Serverhundert Watt für ähnliche Aufgaben benötigt.

- Kombination mit Micro-LLMs erlaubt kleine, autonome KI-Lösungen direkt auf Edge-Geräten.

Vorteile im Vergleich zu klassischen Computern

| Merkmal | Klassischer Computer | Neuromorphic Computing |

|---|---|---|

| Verarbeitung | sequentiell | parallel |

| Energie | hoch | extrem niedrig |

| Lernen | Softwarebasiert | Hardwarebasiert |

| Echtzeit | begrenzt | blitzschnell |

Herausforderungen

- Programmierbarkeit: Neue Paradigmen – alte Software funktioniert oft nicht.

- Standards fehlen: Verschiedene Chips, unterschiedliche Spike-Formate.

- Skalierung: Große Modelle auf neuromorphen Chips sind noch schwierig.

- Integration: Kombination mit klassischen Systemen komplex.

Historischer Kontext

Die Idee ist nicht neu: In den 1980er Jahren entstanden erste neuronale Chips, in den 2000ern spezialisierte Forschungslabore wie IBM und Intel. Neuromorphic Computing ist also die Verschmelzung jahrzehntelanger KI-Forschung mit modernen Hardwaremöglichkeiten.

Zukunftsausblick

Die Vision: Geräte, die lernen, vorausschauen, Entscheidungen treffen, ohne ständig auf die Cloud zuzugreifen.

- Brain-like AI auf jedem Smartphone

- Autonome Roboter mit extrem niedrigem Energieverbrauch

- Erweiterung von Edge Computing durch Intelligenz direkt an der Quelle

Fazit

Neuromorphic Computing und Micro-LLMs sind der Schritt von „denkender Software“ zu „denkendem Gerät“. Die Computer der Zukunft könnten nicht nur schneller, sondern auch schlauer und sparsamer sein – und uns, ähnlich wie ein menschliches Gehirn, beim Denken unterstützen.

Oder um es bildhaft zu sagen: Während klassische Computer wie ein sehr sturer Bibliothekar arbeiten, ist Neuromorphic Computing wie ein quirliger Forscher, der alles gleichzeitig denkt, merkt, lernt und reagiert – blitzschnell und energieeffizient.